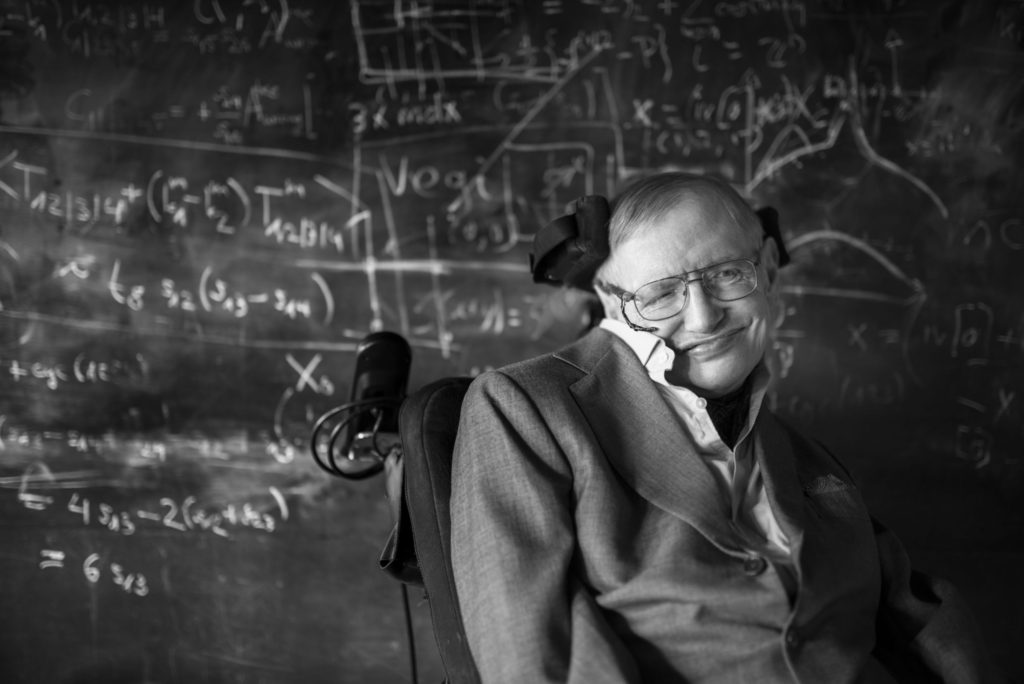

Cuando en 1985 el famoso científico Stephen Hawking perdió la capacidad de hablar se comunicó primero usando tarjetas de ortografía y luego, un programa computacional que le permitía seleccionar palabras y comandos mediante un control manual, sin embargo, la esclerosis lateral amiotrófica o “enfermedad de Lou Gehrig” que padeció pronto le deterioró la capacidad de mover los dedos.

Usó un dispositivo de conmutación en sus anteojos llamado “interruptor de mejilla” para poder encender su computadora y escribir con un ligero movimiento de mejilla.

En 2011 podía escribir una o dos palabras por minuto y para 2014 alcanzó 20 palabras por minuto gracias a una interfaz con un predictor de palabras adaptativo que le permitía seleccionar una palabra después de escribir una letra, algo común en los teléfonos inteligentes actuales.

Así pudo escribir artículos científicos y libros, envió correos electrónicos, redactó conferencias, navegó por internet y habló con su voz robotizada, sin duda, una de las más conocidas en todo el mundo, basada en uno de los primeros dispositivos que tradujeron texto a voz, desarrollada por Dennis Klatt, del MIT, a principios de los años 80.

Klatt creó un algoritmo de conversación con tres voces, una de ellas basada en su propia voz, llamada “Perfect Paul”, que fue la de Hawking hasta el día de su muerte, de la cual decía que tenía una acento mezcla de “escandinavo, americano o escocés”.

un algoritmo de conversación se usó para generar la voz robotizada de Stephen Hawking, llamada “Perfect Paul”, de la cual decía que tenía una acento mezcla de “escandinavo, americano o escocés”.

Al igual que Hawking, miles de personas pierden la capacidad de hablar ya sea por padecimientos neurodegenerativos como la esclerosis lateral amiotrófica (ELA), esclerosis múltiple, demencias, o por alguna parálisis grave causada por un accidente cerebrovascular del tallo cerebral o alguna lesión de médula espinal. Tan solo en EE. UU., se calcula que más de 30 mil personas padecen ELA, y en Mexico se estiman que alrededor de 6 mil personas sufren esta enfermedad incurable, progresiva y mortal.

La ELA ocasiona problemas del habla al atacar las neuronas bulbares, las células nerviosas responsables de llevar mensajes desde las partes inferiores del cerebro (región bulbar) a los músculos que mueven los labios, la lengua, el paladar blando, la mandíbula y las cuerdas vocales.

A medida que avanzan estos trastornos neurológicos se paralizan los músculos cruciales para el habla, la respiración y la función de las extremidades, pero los pacientes preservan sus funciones cognitivas, generando el síndrome de enclaustramiento, en el cual los individuos ya no pueden comunicarse y habitualmente sus respuestas se supeditan a parpadeos o movimientos mínimos.

Preocupados por estos trastornos que impiden a las personas llevar a cabo la necesidad básica de comunicarse, dos equipos de científicos estadounidenses desarrollaron dos interfaces cerebro-computadora (BCI, por sus siglas en inglés), diferentes a las que usó Hawking, pero con el mismo objetivo: restablecer la comunicación en personas con parálisis grave.

Ambos desarrollos tecnológicos basados en neuroprótesis publicados esta semana en la revista Nature pueden decodificar la actividad cerebral en habla de forma rápida, precisa y cubren un vocabulario más amplio y con menos errores que las tecnologías actuales.

dos equipos de científicos estadounidenses desarrollaron dos interfaces cerebro-computadora (BCI, por sus siglas en inglés), diferentes a las que usó Hawking, pero con el mismo objetivo: restablecer la comunicación en personas con parálisis grave.

Neuroprótesis de alto rendimiento

El primero de ellos –denominado “una neuroprótesis del habla de alto rendimiento” y desarrollado por científicos de la Universidad de Stanford encabezados por Francis R. Willett– recopila la actividad neuronal de células individuales con una serie de finos electrodos insertados en el cerebro y entrenaron una red neuronal artificial para decodificar las vocalizaciones (leer en https://doi.org/10.1038/s41586-023-06443-4).

“La pérdida del habla es devastadora porque perjudica sustancialmente la comunicación y provoca aislamiento social”, indican los científicos en el artículo.

Anteriormente, agregan, se había demostrado que es posible decodificar el habla de la actividad cerebral de una persona con parálisis, pero solo en forma de texto y con velocidad y vocabularios limitados.

Los científicos de Stanford experimentaron su dispositivo con una paciente con esclerosis lateral amiotrófica llamada Pat Bennet, de 68 años, cuyo padecimiento le permite moverse –aunque cada vez con mayor dificultad–, pero no puede comunicarse ya que no puede mover adecuadamente los músculos de mandíbula, labios, lengua o laringe para expresar palabras inteligibles.

Con esta nueva tecnología pudo comunicarse a una velocidad promedio de 62 palabras por minuto, 3.4 veces más rápido que el récord anterior de un dispositivo similar, acercándose a la velocidad de la conversación natural de alrededor de 160 palabras por minuto.

Los científicos y la paciente lograron una tasa de error de palabras del 9.1% utilizando un vocabulario de solo 50 palabras, lo que supone 2.7 veces menos errores que las tecnologías previas de voz. Asimismo, obtuvieron una tasa de error del 23.8% con un vocabulario de 125 mil palabras.

Cómo lo lograron

A través de una neurocirugía, le implantaron dos placas de silicio de alrededor de 8 x 4 cm en el cráneo, cada una con dos conjuntos de 64 microelectrodos dispuestos en rejillas de 8 por 8.

Las placas están unidas a finos cables de oro que salen del cráneo a través de pedestales atornillados, que luego se conectan mediante un cable a una computadora. Se colocaron en la capa más externa del cerebro, en dos regiones amplias asociadas al lenguaje: la corteza premotora ventral y el área de Broca.

Recogen las señales de las neuronas al momento de pensar en las palabras y transmiten la información a un programa de lenguaje basado en inteligencia artificial que recibe y decodifica la información que emana del cerebro de Bennett.

El programa aprende a distinguir la actividad cerebral asociada con los fonemas que componen el inglés hablado. Introduce sus mejores conjeturas sobre la secuencia de los fonemas intentados por Bennett basado en un sofisticado sistema de autocorrección, que convierte los flujos de los fonemas en la secuencia de palabras que representan. Traduce el pensamiento en habla.

“Descubrimos que el habla pudo ser decodificado con mayor precisión de la matriz ventral, mientras que la matriz dorsal (área de Broca) contenía más información sobre los movimientos orofaciales (de la boca)”, señalan los científicos.

“Este sistema está entrenado para saber qué palabras deben ir antes que otras y qué fonemas forman qué palabras”: francis Willett, de la universidad de stanford.

Este resultado es consistente con datos de imágenes por resonancia magnética funcional (fMRI) en estado de reposo del Proyecto Conectoma Humano, que señala la región ventral como parte de una red de neuronas relacionadas con el lenguaje.

El sistema pudo decodificar 33 movimientos orofaciales con un 92% de precisión, 39 fonemas con un 62% de precisión y 50 palabras con un 94% de precisión.

“Este sistema está entrenado para saber qué palabras deben ir antes que otras y qué fonemas forman qué palabras”, explicó Willett en un comunicado de la Universidad de Stanford. “Si algunos fonemas se interpretaron incorrectamente, aún se puede hacer una buena suposición”.

Tanto el algoritmo del programa de inteligencia artificial como Pat Bennet tuvieron que entrenar para reconocer qué patrones de actividad cerebral estaban asociados con qué fonemas tratando de repetir una serie de frases comunes. Mientras hacía esto, la actividad cerebral era traducida en un flujo de fonemas y luego eran ensambladas en palabras mediante un sistema de autocorrección.

Willett aclaró que este es un primer prototipo, no un dispositivo real que la gente ya pueda usar en la vida cotidiana. “Pero es un gran avance hacia el restablecimiento de una comunicación rápida entre las personas con parálisis que no pueden hablar”.

“Imagínese”, escribió Bennett en el comunicado, “cuán diferente será realizar actividades cotidianas como ir de compras, asistir a citas, pedir comida, ir al banco, hablar por teléfono, expresar amor o aprecio (incluso discutir) cuando las personas no verbales puedan comunicar sus pensamientos en tiempo real”.

“Nuestro objetivo es restaurar una forma de comunicación plena y encarnada, que es realmente la forma más natural de hablar con los demás”, Edward Chang, de la Universidad de California en San Francisco.

Decodificador de voz y avatar

En la otra investigación llamada “una neuroprótesis de alto rendimiento para decodificación de voz y control de avatar” llevada a cabo en la Universidad de California en San Francisco y Berkeley, encabezada por Edward Chang, se desarrolló una interfaz cerebro-computadora (BCI) basado en un método similar para acceder a la actividad cerebral, pero con mayor precisión (ver: https://doi.org/10.1038/s41586-023-06443-4 R ).

Para ello usaron electrodos no penetrantes que se colocan en la superficie de la cabeza y detectan la actividad de muchas células en sitios de toda la corteza del habla.

Esta interfaz decodifica señales cerebrales para generar tres salidas simultáneas: texto, voz audible y un avatar parlante. Los investigadores desarrollaron un programa basado en un modelo de aprendizaje profundo (de inteligencia artificial) para descifrar los datos neuronales recopilados de una paciente llamada Ann con parálisis severa, causada por un derrame cerebral, mientras pensaba oraciones completas en silencio.

“Nuestro objetivo es restaurar una forma de comunicación plena y encarnada, que es realmente la forma más natural de hablar con los demás”, dijo Chang, de la Universidad de California en San Francisco. “Estos avances nos acercan mucho más a una solución real para los pacientes”.

El equipo de Chang demostró previamente que era posible decodificar señales cerebrales en texto en un hombre que también había sufrido un derrame cerebral muchos años antes, pero el estudio actual demuestra algo más ambicioso: decodificar las señales cerebrales en la riqueza del habla, junto con los movimientos que animan el rostro de una persona durante una conversación.

La traducción de la información generada en el cerebro de la paciente a texto ocurrió a una velocidad media de 78 palabras por minuto, que es 4.3 veces más rápida que el récord anterior y se acerca aún más a la velocidad de la conversación natural.

Los investigadores implantaron una placa, delgada como papel, con 253 electrodos en la superficie del cerebro de la mujer, detectando las señales del habla que, si no fuera por la lesión, habrían llegado a los músculos de la cara, lengua, mandíbula y laringe, y enviaron la información a través de un cable a un sistema computarizado.

Durante semanas, la participante trabajó con el equipo para entrenar los algoritmos de inteligencia artificial del sistema para reconocer sus señales cerebrales. Esto implicó repetir, una y otra vez, diferentes frases de un vocabulario conversacional de mil palabras hasta que la computadora reconoció los patrones de actividad cerebral asociados con los sonidos o fonemas.

Esta interfaz logró una tasa de error de palabras del 4.9 % al decodificar oraciones de un conjunto de 50 frases, lo que supone cinco veces menos errores que las interfaces de voz actuales. Se logró una tasa de error de palabras del 25% al decodificar oraciones en tiempo real con un vocabulario de más de mil palabras, y las simulaciones fuera de línea mostraron una tasa de error de palabras del 28% usando un vocabulario con más de 39 mil palabras.

Las señales cerebrales también se tradujeron directamente en sonidos del habla sintetizada con una tasa de error de palabras del 28% para un conjunto de 529 frases, y utilizando grabaciones familiares anteriores, se personalizó con la voz de la propia paciente antes de sufrir la lesión.

Este sistema de la Universidad de California también decodificó la actividad neuronal en movimientos faciales de un avatar durante el habla, así como expresiones no verbales. Durante meses se demostró una decodificación estable y de alto rendimiento.

Este desarrollo multimodal ofrece más posibilidades para que las personas con parálisis se comuniquen de una manera más natural y expresiva.

El siguiente paso de ambos desarrollos será crear versiones inalámbricas que se podrán conectar a programas instalados en teléfonos inteligentes o tabletas que brindarán a las personas mayor capacidad de comunicación y autonomía lo que dejará profundos efectos en su independencia y en sus interacciones sociales.

El siguiente paso de ambos desarrollos será crear versiones inalámbricas que se podrán conectar a programas instalados en teléfonos inteligentes o tabletas que brindarán a las personas mayor capacidad de comunicación y autonomía.